我们应该相信ChatGPT,和它走过的路吗?

本文来自微信公众号:甲子光年 (ID:jazzyear),作者:甲小姐,原文标题:《甲小姐谈ChatGPT:为了不沦落为“废话文学”,必须思考清楚几个议题》,题图来自:视觉中国

功能性vs人格化:两种本质相反的牵引力

ChatGPT作为史上界面最朴素却圈粉最快的科技产品,给人的冲击感不是发生在眼球层面,而是颅内层面的。

火到“上头”背后有两重原因:

一方面是功能性的胜利,如帮人们写作文、编程、收集结构化资料,其内容生成的速度和质量甚至超出很多在AI行业深耕多年的从业者的预期;

另一方面是人格化的胜利,它会理解意图、声明立场、表达恭喜、道歉、自我修正答案,并拥有上下文的记忆连贯性,体现出实时的自主学习能力,简言之,就是“像人”。

打个比喻,因为渴望飞行又没有翅膀,人类造出了飞机。一直以来,AI界一直在“造飞机”,之前各类突破性进展都让飞机的功能性越来越强,而ChatGPT却似乎造出了一只“鸟”。这也是为什么ChatGPT被很多从业者定位为“通用人工智能(AGI)”雏形的原因。

功能性与人格化看似在这一代ChatGPT上得到了平衡,但从本质看,二者有着相反的牵引力。

如果追求功能性,重点是回答本身的正确、精准、靠谱,最好其回答有明确的可溯源的出处。排除写作文等本来就需要发挥创意的功能,不同人问同一个问题应该有类似的答案(千人一面),因为大部分功能性问题是在寻求正确解或最优解。这更像“改进版搜索引擎”,New Bing就是这么做的,这有其明确的价值,却不是革命性的体验;

如果追求人格化,重点是交互感、创新性、超预期,意味着不能有死记硬背的感觉,因为死记硬背并不是人类学习与交互的惯性方式,这意味着回答要有个性、丰富性、多样性甚至狡猾性。

诡异的地方恰恰在于,后者往往比前者看起来更“聪明”,更“机灵”,但往往更“不可信”。

在今天版本的ChatGPT中,你可以轻易诱导它犯错,而且它会犯许多出乎你预料的错,有的回答会一本正经地胡说八道,有的回答会陷入滔滔不绝的“废话文学”,但由于它的表达方式足够讨巧,会认错、道歉,会自我“澄清”,因此这甚至让你感到开心、好玩、可爱——

ChatGPT正是以人格化特征建立了用户心理的“容错性”,而这也是为什么人格化相比功能性是今天ChatGPT大火更显著的助燃剂(大家纷纷在朋友圈晒问答,被分享的段落绝大部分是ChatGPT表现出情商的片段、超预期的部分、搞错的部分)。

在诸如“评价一下甲子光年”这样的问题中,ChatGPT的回答是带有狡猾性与迎合性的。如果你在对话前文表达了对甲子光年的认可,ChatGPT马上就会附和,是一个机灵的捧哏,但换个人再问,回答立刻变成不知道——ChatGPT只是在当前对话中根据用户反馈进行修正,当我们重启一个对话,测试相同的问题时,ChatGPT会表现出失忆或犯错。

从原理看,今天的ChatGPT之所以给人一种很强的“理解力”,是因为ChatGPT是“重新表达”材料,而不是从数据库中逐字引用,这让它看起来像一个学生用自己的话表达思想,而不是简单地重复它读过的东西。

“重新表达”和搜索是两件事——正是因为这种“重新表达”,造成了ChatGPT“理解”了材料的“错觉”。

然而,举一反三和胡编乱造间有一个微妙的界限,这个界限在人与人之间的对话中往往也是模糊的。这就引发了一个关键问题:ChatGPT可信吗?

什么是可信?如何辨别其回答是否可信?这些问题背后,还有一个前置性问题:ChatGPT的一系列延伸价值和未来想象,是否需要建立在“可信”的基础上?

不用可信vs必须可信:少部分人细思恐极,大多数人惶然而不自知

很多人想当然地以为,现在不够“可信”,是因为模型还不够大、数据还不够多、技术还不够强,或者是因为缺乏安全技术与监管手段,这是对“可信”的理解还不够透彻。

内容分两种,一种的本质属性不依赖“可信”,一种的本质属性必须“可信”。

前者往往是kill time(消磨时间)类型内容,核心是抓住用户的时间,占领时间越多越好,用户越上瘾越好。典型代表是今日头条、抖音、各类游戏。字节系诸多产品最初都以放弃可信度换取UGC的海量内容,以个性化取代了绝对权威,以“最适合的”取代了“最优解的”。文章视频从相对高门槛的作者生产、编辑分配,变成相对低门槛的用户生产、算法分配,构建了算法推荐的世界;

后者往往是save time(节省时间)类型内容,核心是准确、科学、实用、工具属性,典型代表是搜索引擎、维基百科。很多人近来逐渐减少在搜索引擎上投入的时间,转而去知乎甚至B站搜索,也恰恰是因为商业导流的泛滥和各巨头间内容围墙的普遍存在,搜索结果正变得没那么可信、没那么直接。

对准确性有强诉求的人群将很快发现,如果无法保证ChatGPT的可信度,而对生成内容的校验方式又需要回归到搜索引擎,或者需要溯源内容出处以做再判断(New Bing就是以罗列出处链接的方式来嫁接回答内容与可信出处),其价值将大打折扣。试想,如果ChatGPT每一次给我的回答,我都要交叉验证,那不是多此一举吗?

特德·姜在《ChatGPT是网上所有文本的模糊图像》一文中写道:“任何对内容工厂有好处的东西都不适合搜索信息的人。”他用压缩算法做了一个类比:如果一种压缩算法被设计成在99%的原始文本被丢弃后重建文本,我们应该预料到,它生成的很大一部分内容将完全是捏造的。

换言之,需要kill time的人和需要save time的人往往是两拨人。需要个性化生成式内容的人和需要搜索引擎的人的本质诉求是不同的。前者是“1到正无穷”,需要创意和与众不同,不存在“最优解”;后者是“无穷中寻一”,需要精确、准确、正确,要无限逼近全局最优解。

ChatGPT是为了kill time而生还是save time而生呢?两条路都有巨大的商业前景,都不可怕,但最可怕的是:你似乎是可信的,但其实不然。最怕的是你以一种看似可信的方式,出现在了需要可信的场景,却交付了不可信的内容。

当然,一个自然的问题是:能不能既要也要呢?能不能在消除不可信的同时,保留人格化、创意化的天马行空的部分?这是一个目前业界各类产品都未能验证的期待。

可信意味着可记录、可验证、可追溯、可审计,而这很可能与大模型理念的本质就是冲突的。我们在昨天的文章里写到,考虑到安全隐患,ChatGPT的发布公司,OpenAI,在安全保护机制方面对ChatGPT进行了较多限制,ChatGPT似乎正因此处于一种“情绪崩溃”的状态。(见《第一批因ChatGPT坐牢的人,已经上路了》)

我之所以这么早强调“可信”这一点,是因为随着大型语言模型生成的文本在网络上发布得越多,网络整体的信息质量就变得越模糊。伴随信息过载,可信愈发困难,而“可信”这个问题越晚一天解决,就越难解决。用我同事涂明的话说,就是“其实信权威和信机器没什么两样,如果机器个性化更强,最后就可能变成信自己,信息极化。”

从“个性化捧哏”到“个性化忽悠”只隔着一层窗户纸。少部分人细思恐极,大多数人惶然而不自知——难道出路在于“每个人都是自己获取信息的第一责任人”?

真命题vs假命题:?AGI不是一个好命题

前文提到,ChatGPT被很多从业者定位为“通用人工智能(AGI)”,因为从产品效果来看,ChatGPT的智能水平已经表现出某种人类心智的特征,有人格化属性,有灵动的“有机感”。我们知道有机物和无机物最本质的区别是有机物含碳,但AGI与非AGI的边界却没有这么清晰。

为什么?因为AGI本身就不是一个真命题、好命题。

字面意义理解,AGI为“通用人工智能”,而什么是通用?什么是智能?人脑算通用吗?文理科生的思维逻辑与知识储备差异极大,从字面意义理解,人脑也不算通用智能。从沃尔夫假说来看,语言是思维的映射,母语英语的人和母语中文的人,本身思维方式就呈现出巨大的不同,脑补能力也不同。

那么,什么是“理解”?

如果一个大语言模型已经编译了大量学科术语之间的相关性,多到可以对各种各样的问题提供合理的回答——我们是否应该说它实际上理解了该学科?

这是一个哲学命题,我的答案是,能表现得理解,就是理解。

关于“理解”乃至“意识”,人类自己也始终没有精准定义。我们做AI,并不是要从原理到外在复刻一个人类大脑,只要表现出人类对话的外在特征,就可以定义为理解与表达。(否则还能怎么办呢?)

有很多网友质疑ChatGPT并非强人工智能,理由无非是“ChatGPT虽然能够做到XXX,但是它并没有理解”,这种质疑相当于是在争辩“如果一个智能被机器实现了,就不能被叫做智能”,这是悖论不是辩论。或者说,今天争论ChatGPT是“强人工智能”还是“弱人工智能”,也许不是一个真问题。

一个更务实的问题是:这个“9岁儿童”的智能会在“18岁成年”时长成什么样子?其极限在哪里?

圣塔菲研究所前所长Geoffrey West在科普书《规模》中揭示了规模法则(scaling law)。在West眼中,有一种不变的标准可以衡量看似毫无关联的世间万物——无论是生物体的体重与寿命,还是互联网的增长与链接,甚至是企业的生长与衰败,都遵循规模法则。规模法则关心复杂系统的特性如何随着系统大小变化而变化。

以规模法则的视角看待ChatGPT背后的大模型,一个自然的问题是:模型一定是越大越好吗?如果数据量足够大、算力足够充沛,是否AI的效果会无限上扬?

面对这个问题,业界多方的答案是Yes and No。

持Yes观点的人认为,现在的“大”并不足够大。

从历史角度看,上世纪60年代,图灵奖获得者马文·明斯基在批判第一代神经网络时,认为它所需要的计算量很大,当时他说的“大”指的是数十KB。如今看来,这种规模是极小的。试想一下,在二十年后,今天的大模型是否还能称之为大模型呢?

从用脚投票角度看,不同公司的LLM(Large Language Model,大语言模型)基本都是基于Transformer构建的自回归、自我监督、预训练、密集激活模型,他们接连表现出惊人的能力,证明了more is different。

从内容类型角度看,目前ChatGPT还是针对文本对话或者写代码,下一步一定会拓展到图像、视频、音频等多模态,乃至逐步纳入AI for Science、机器人控制等领域,这是通往AGI的必经之路,目前只是刚刚开始,在短期的未来,当然要一鼓作气地做“大”。

持No观点的人认为,大模型虽好,但其性能有一个上限,虽然这个上限尚不明确。

从通用性的角度看,目前的基础大模型不会选择根据低频数据更新参数,否则大模型就会因为对某些长尾数据进行过拟合而失去通用性。

从专有领域的角度看,硬件在进行推理时,往往无法承载超规模的预训练模型,人们需要针对具体应用进行模型的裁剪和优化。此外,专有领域也不一定需要超大规模的模型,不恰当的网络架构也许会造成对计算资源极大的浪费。值得一提的是,GPT-3 之所以取得了非常好的效果,并不仅仅是是因为“大”,也包括他们找到了一种“提示”的方法,这些方法也可以应用到非常小的模型上。

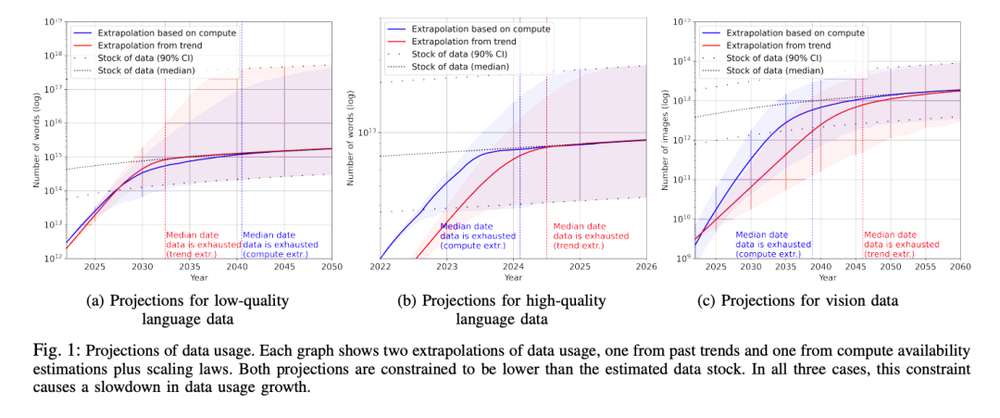

从数据供给的角度看,《Will we run out of data? An analysis of the limits of scaling datasets in Machine Learning》(P Villalobos, J Sevilla, L Heim, T Besiroglu, M Hobbhahn, A Ho [University of Aberdeen & MIT & Centre for the Governance of AI & University of Tübingen] (2022) )的估算结论是到2026年左右,高质量的NLP数据将会用光,低质量NLP数据会在2030到2050年用光,而低质量图像数据会在2030到2060年用光。

这意味着:要么到时我们有新类型的数据源,要么我们必须增加LLM模型对数据的利用效率。否则,目前这种数据驱动的模型优化方式将会停止进步,或者收益减少。

研究表明,可用数据将在未来被“消耗殆尽”

此外还有一些问题:我们还没有充分使用已有的数据;超大规模模型的调优问题还没有被解决;如何从预测任务迈向决策任务……一个最本质的问题是,是否给出足够的时间、足够的钱、足够的数据,所有问题最终都能够被大模型解决?大模型的极限在哪里?

比尔·盖茨评价ChatGPT出现的重大历史意义不亚于互联网和个人电脑的诞生,这个表述究竟是否高估,与大模型这条能力曲线的走势息息相关。

商业价值vs商业模式:发明电灯的人不一定直接享受到电力革命的红利,却依然值得歌颂

另一种对ChatGPT的普遍担忧是成本问题。

有网友表示:“训练大型人工智能模型的成本已在数量级上逼近人类愿意拿出来的最大成本,若人类的总功率增量不能加速,模型参数的持续增长无法加速。”

对此,我更认同理想汽车CEO李想在朋友圈的表达:“搜索引擎公司看待ChatGPT的成本,和燃油车企业早期看电动车的成本如出一辙。他们都在想:这么高的成本,咋盈利呀?”

今天,用成本与收益的角度来评价ChatGPT为时过早。对于突破性技术进展而言,从一开始就以商业维度来考量似乎有失公允,质疑ChatGPT烧钱,类似于质疑探索航天事业烧钱。

首先,AI行业本身就有工业界反哺科学界的特征。类似ChatGPT这种迈向AGI之路的探索看似发生在工业界,但其价值本身是外溢出商业范畴的,是科学进展的重要组成部分。发明电灯的人不一定直接享受到电力革命的红利。但如果拨开时光机回到过去:是不是应该鼓励发明电?

其次,就算在商业语境范畴内看待这项技术,如果一项技术的成本只是时间问题,如果可以证明其成本随着时间推移会逐渐降低到合理值,那么这就不是一项技术在早期阶段需要被挑战的“主要矛盾”。新兴技术的账怎么算,我个人的观点是,更需要去看这条道路的第一性原理,而不是过去、现在、未来几年烧不烧钱,能不能赚钱。

再次,ChatGPT离赚钱没那么远。以ChatGPT对程序员的助力为例:依据GitHub的数据,2021年,中国有755万程序员,排名全球第二。放眼全球,程序员数量已经超过7300万,比2020年增长了1700万。根据预测,2025年GitHub上的程序员估计能达到1亿。这里面,随便几个百分点的降本增效,都是一个巨大的市场空间。

此外,大家很关注ChatGPT对搜索引擎的替代,但另一个巨大的市场是office类产品、在线文档类产品和ChatGPT的融合——如果能够让写word、做Excel、画PPT的效率提升50%,我会毫不犹豫给甲子光年全员开通付费账号。

一直以来,我都认为“商业价值”与“商业模式”是两件事。商业模式有两种,一种是人为事先设计的,另一种是做好商业价值之后伴生而来事后总结的,伟大的公司往往是先有商业价值而后有商业模式,而不是相反。

对于技术突破而言,模式永远是结果而非原因。在本该求因的阶段求果,可能抓错了主要矛盾,也丧失了战略机遇。至少,我国AI距离世界最先进水平的差距并不是财力。当然,考虑到成本问题,未来也许会出现“股份制大模型”,多方群策群力,共建超级平台,这都是“术”层面的问题。

理论洁癖vs暴力美学:长期信仰来自深刻理性

托马斯·库恩在《科学革命的结构》中提出,科学进步的轨迹是跳跃式的。科学通过“革命”的方式进步,通过摆脱那些遭遇到重大困难的先前世界框架而进步。这并非一种朝向预定目标的进步。它是通过背离那些既往运行良好、但却不再能应对其自身新问题的旧框架而得以进步。

这个角度看,我们无疑正在经历一场关键的科学革命。相比于其他学科以及早年间的AI派系,今天的AI行业更趋近于一场集体的范式迁移,这是由底层哲学观牵引的。

ChatGPT背后的GPT系列体现了LLM应该往何处去的发展理念。很多人开始相信,揭开AGI的真正钥匙正在于:超大规模及足够多样性的数据、超大规模的模型、充分的训练过程。这条道路看似朴素,却足以让AI表现出智能“涌现”的能力,未来也许会持续带来意想不到的惊喜和惊吓。这种思想简言之就是将“参数至上和数据至上”的思想发挥到极致,从细分技术“分而治之”到“大一统、端到端”,从理论洁癖走向暴力美学。

OpenAI并非这种哲学的奠基者。1956年达特茅斯会议首次提出“AI”概念后,AI路径之争、派系之争始终存在。自深度学习诞生以来,AI行业的发展越来越像是一个暴力的拟合机器,多次里程碑节点都来自于LLM模型规模的增长,而非突破性理论的推动(当然不能说大模型没有突破性技术,只是这种技术的实现路径不是理论洁癖者所甘心的画风,比如做超大规模的LLM模型对技术团队的工程实现能力要求是非常高的,仿佛“驯兽师”一般,包含无数技巧、脏活累活)。

ChatGPT之所以到达今天的高度,是OpenAI坚持信仰的结果。OpenAI基本坚定地把LLM看做是通往AGI的一条必由之路。2018年OpenAI提出GPT模型,在风头不如BERT的情况下,再次提出GPT-2模型;随着Google提出T5模型之后,再次提出GPT-3模型,今天依然在同样的路径上矢志不渝。

这颇有“以凡人之身躯领悟天之意志”的决绝感。大部分人都是因为看见才相信,OpenAI对技术判断的前瞻性和其笃定信念是黄金一样可贵的东西。

我的观点是:信仰一定不是凭空产生的,信仰是需要对问题的深刻认知才会产生。OpenAI看似疯狂,却一定不是无脑all in。我一直相信长期信仰(而非短期狂热)的背后是深刻的理性。

此外值得一提的是,今天的热潮正在推动着国内很多宣传与决策的快速跟进,这种跟进往往是建立在认知还没有清晰之前,这很容易导致“走偏”。我个人并不期待AI的发展需要全球走向完全相同的路径。这不仅容易偏废,也会导致产业的脆弱性——人各有志,AI为何不可多样性呢。就算是直接对标效而仿之,每一次弯道超车也要清醒论证,否则可能不是弯道超车,而是弯道翻车。

有意瞄准vs无意击发:一场企业家精神对科学界的反哺

最后说点题外话,这次ChatGPT的爆发,让我想起了八个字“有意瞄准,无意击发”——这八个字用来形容狙击手。你需要像狙击手一样专注,朝对的方向,心无旁骛地瞄准,至于兔子什么时候出来、枪什么时候会响,只是时间问题。

历史是在钟摆声中进步的。回顾人类文明发展史,在古代,人们还没有掌握万有引力定律和牛顿定律之前,可能会直接记录下物体各种运动现象,用眼睛而非逻辑去研究星星,而万有引力定律和牛顿定律之后,方法自然不一样了。打个比方,人们通过观测、记录来研究星星,正如大模型;人们发现万有引力定律,就是理论突破。大模型→理论突破→大模型→理论突破,文明进步总是在螺旋中上升。当理论越强,对模型的依赖越小。

感谢ChatGPT在岁末年初交付关键一役,业界已经冰冷太久。此时此刻的全球科技产业界士气大涨,就这一点而言,OpenAI已是功不可没。自我2015年开始写和AI相关文章开始,冷冷热热也经历了好几轮。ChatGPT再次验证了科技行业的不变真理——高估低估常有,但永远没有盖棺定论的一天。

科技行业永远需要鲶鱼。ChatGPT与其说是热点,更应该定位为拐点。所以,无论ChatGPT的高温天气能持续多久,我都愿意为其添一把火——这是一场企业家精神对科学界的反哺,一场好久不见的暴力美学,一场技术信仰的胜利。

本文来自微信公众号:甲子光年 (ID:jazzyear),作者:甲小姐