谷歌实现量子计算第二个里程碑?

本文来自微信公众号:新智元 (ID:AI_era),作者:新智元,原文标题:《量子计算第二里程碑!谷歌实现量子纠错突破,150多位作者成果登Nature》,头图来自:视觉中国

2019年,谷歌首次宣称实现量子霸权,创下首个里程碑。

3年之后,这家公司宣布已经达到通往构建大型量子计算机道路上的第二个关键里程碑(M2)。

有史以来首次通过增加量子比特来降低计算错误率!

官方博客称,量子纠错(QEC)通过多个物理量子比特,即“逻辑量子比特”,对信息进行编码。

这一方法被认为是大型量子计算机降低错误率来进行计算的唯一方法。

最新研究成果已发表在Nature期刊上。

论文链接:https://www.nature.com/articles/s41586-022-05434-1

不说别的,这篇论文阵容有多强大,瞅瞅作者数量就知道了。

有150多位科学家参与了本次研究。

物理量子比特到逻辑量子比特

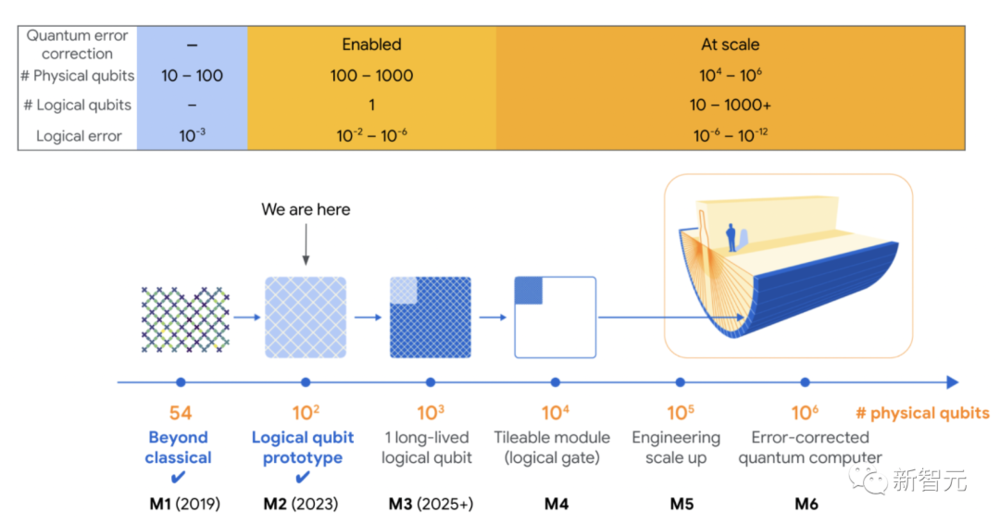

2020年,谷歌曾发布了一份量子计算路线图,共有六个关键里程碑。

量子优越性(量子霸权)是第一个里程碑,而当前最新成果代表了M2。

最后一个里程碑M6是实现100万个物理量子比特组成的量子计算机,编码1000个逻辑量子比特,到那时便可以实现量子计算机商业应用的价值。

为什么要纠错呢?需要明确的是,所有计算机都会出错。

要想量子计算机能够处理普通计算机无法解决的问题,比如将大整数分解为素数,纠错是不可避免的。

对于普通计算机来讲,其芯片以位(可以表示0或1)的形式存储信息,并将一些信息复制到冗余的纠错位中。

当发生错误时,芯片可以自动发现问题并进行修复。

然而,在量子计算中,却无法做到这一点。量子比特是量子信息的基本单位,量子比特是0和1的量子叠加。

如果一个量子比特的完整量子态不可挽回地丢失,则无法读出信息,也就意味着它的信息不能简单地复制到冗余量子比特上。

现在,谷歌量子团队找到了一种全新的量子纠错方案:

即通过在一组物理量子,而不是单个量子中编码信息的量子比特,称为“逻辑量子比特”。

量子计算机可以使用一些物理量子比特来检查逻辑量子比特的状况并纠正错误。物理量子比特越多,就越能降低错误发生率。

另外,使用多个量子比特进行量子纠错的优势在于它可以不断扩展(Sacling)。当然,物极必反,添加更多量子比特也会导致其中两个量子同时受到错误影响的机会。

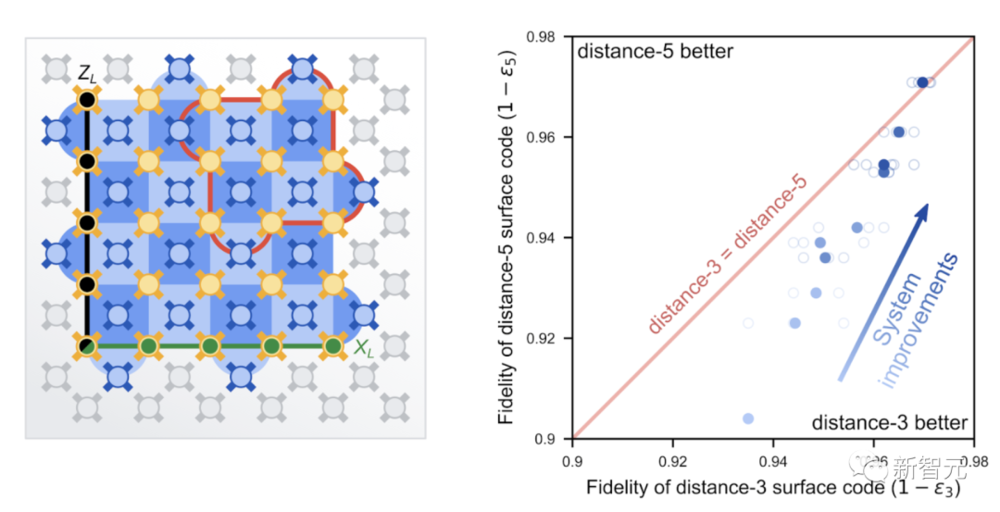

为了解决这一问题,谷歌研究人员对量子芯片Sycamore的量子比特进行了改进,研究了2种不同大小的逻辑量子比特。

一个是由17个量子比特组成,一次能够从一个错误中纠错;另一个由49个量子比特组成,可以从两个同时发生的错误中纠错。

实验结果显示,其性能优于17个量子比特的版本。

图片来自:Google

表面码逻辑量子比特纠错

谷歌团队是如何具体地实现这一成果呢?

举一个经典通信中的简单例子:Bob想通过噪音的通信信道向Alice发送一个读为“1”的位。他认识到如果该位翻转为“0”则消息丢失,因此改为发送三个位“111”。

如果一个人错误地翻转,Alice可以对所有接收到的位进行多数表决(一个简单的纠错码),仍然能够理解预期的消息。

若将信息重复三次以上,即增加编码的“大小”,将使编码能够纠正更多个别错误。

表面码则采用了这一原则,并设想了一个实用的量子实现。它必须满足两个额外的约束。

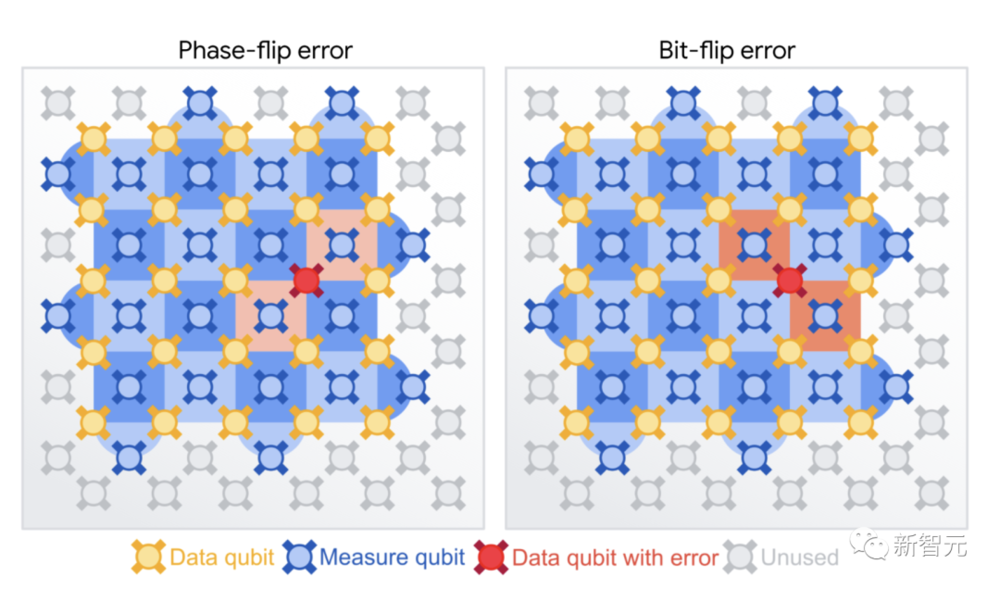

首先,表面码必须能够纠正不只是位翻转(从0到1个取一个量子比特),而且相位翻转。这个错误是量子态所独有的,并将量子比特转换为叠加态,例如从0+1到0-1。

其次,检查量子比特的状态会破坏其叠加态,因此需要一种无需直接测量状态即可检测错误的方法。

为了突破这些限制,我们在棋盘上排列了2种类型的量子比特。

顶点上的“数据”量子比特构成逻辑量子比特,而每个正方形中心的“测量”量子比特用于所谓的稳定器测量。

这些测量结果告诉我们这些量子比特是否完全相同/不同,表明发生了错误,但实际上并没有揭示各个数据量子比特的值。

图片来自:Google

通过棋盘模式平铺两种类型的稳定器测量,以保护逻辑数据免受位翻转和相位翻转的影响。

如果一些稳定器测量值记录了错误,则使用稳定器测量值中的相关性来识别发生了哪些错误以及发生在何处。

就比如上面例子中Bob给Alice的消息随着编码大小的增加而变得更加强大,一个更大的表面码可以更好地保护它所包含的逻辑信息。

表面码可以承受一定数量的位和相位翻转误差,每个误差小于距离的一半,其中距离是在任一维度上跨越表面代码的数据量子比特数。

问题是每个物理量子比特都容易出错,所以编码中的量子比特越多,出错的几率就会越大。

为此,物理量子比特的误差必须低于所谓的“容错阈值”。对于表面码来说,这个阈值是相当低的。

最新实验便证明了这一点。

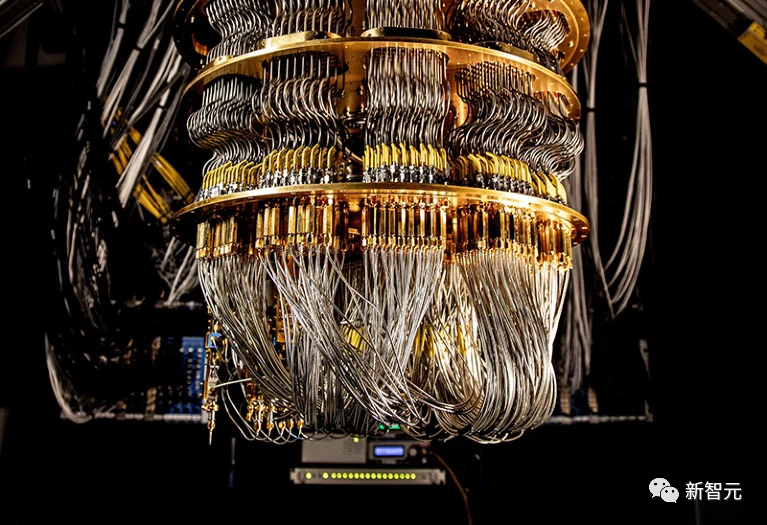

实验运行在谷歌最先进的第三代Sycamore处理器架构,为QEC进行了优化,使用了全面改进的表面码。

为此,研究人员对其量子计算机的所有部件进行了7大改进,包括量子比特的质量、控制软件,再到用于将计算机冷却到接近绝对零度的低温设备。

图片来自:Google

研究人员通过实验来比较基于17个物理量子比特distance-3表面码(ε3)和基于49个物理量子比特distance-5表面码(ε5)的逻辑错误率之间的比率。

图片来自:Google

实验结果如上图右所示,较大表面码展现出能够实现更好的逻辑量子比特性能(每周期2.914%逻辑错误),优于较小的表面码(每周期3.028%逻辑错误)。

谷歌称,虽然这可能看起来是一个小的改进,但是不得不强调这一结果是自Peter Shor的1995年QEC提案以来该领域的首创。

较大编码优于较小编码是QEC的关键特征,所有量子计算架构都需要跨过这一障碍,才能降低量子应用的低错误率。

未来之路

上面这些结果表明,我们正进入一个实用的QEC新时代。

过去几年,谷歌的Quantum AI团队一直在思考:该如何定义这个新时代的成功,如何衡量一路走来的进步?

他们的最终目标是,展示一种在有意义的应用中,使用量子计算机所需的低错误的途径。

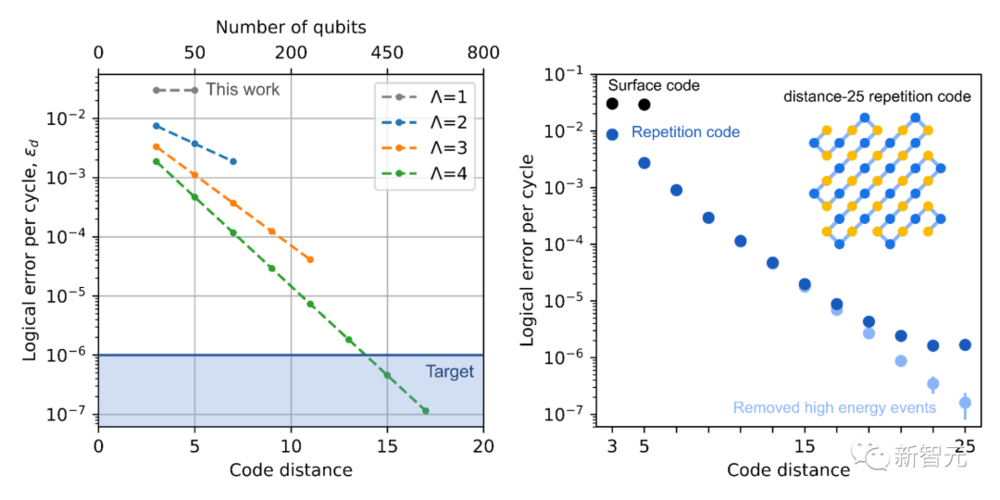

因此,专家们的目标仍然是在每个QEC周期中达到10^6分之一或更低的逻辑错误率。

左图:改进表面代码的性能(由量化)和规模(由代码距离量化)后,会取得的预期进展。右图:实验测量的每个周期的逻辑错误率与一维重复代码和二维表面代码的距离。图片来自:Google

在左图中,专家们勾勒出了实现这一目标的路径。

随着继续改进物理量子比特(以及逻辑量子比特的性能),他们希望逐渐将从接近1增加到更大的数字。

图中显示,当=4,代码距离为7(也即577 个质量足够好的物理量子比特)时,将产生低于10^6分之一的逻辑错误率。

虽然取得这个结果还需要几年,但今天的硬件可以探测到如此低的错误率,已经是一项可喜的进步了。

虽然二维表面代码可以让专家们纠正位和相位翻转错误,但他们也可以构建一维重复代码,这种代码只能解决一种类型的错误,要求不严格。

而在右图中可以看到,距离为25的重复代码,已经可以达到接近10^6分之一的每周期错误率。

在如此低的错误率下,可以看到表面代码尚无法观察到的新型错误机制。通过控制这些错误机制,就可以将重复代码的错误率提高到接近10^7分之一。

图片来自:Google

为达到这一里程碑,整个团队已经专注了三年。

之后,团队预计将引入容错机制,以指数方式抑制逻辑错误,并解锁第一个有用的纠错量子应用程序。

并且团队会继续探索量子计算机能解决的问题,范围包括凝聚态物理、化学、材料科学和机器学习。

参考资料:

https://www.nature.com/articles/d41586-023-00536-w

https://www.nature.com/articles/s41586-022-05434-1

https://ai.googleblog.com/2023/02/suppressing-quantum-errors-by-scaling.html

本文来自微信公众号:新智元 (ID:AI_era),作者:新智元