模拟计算可以卷土重来吗?

我们生活在一个以数字处理为主的模拟世界中,但这可能会改变。领域特异性以及对更高水平优化的渴望可能会为模拟计算提供一些显着优势——以及卷土重来的可能。

数字缩放和灵活性的优势将模拟和数字之间设立了明显的分割线。模拟数字转换通常在传感器和执行器中或非常靠近传感器和执行器完成。而通信一直是一个难题,无论是有线的还是无线的,都不会默认数字化的需求。

图 1:1960 年代的 Heathkit 模拟计算机。资料来源:维基

但即将发生一些重大变化,包括:

从经济意义上讲,芯片扩展正在放缓或停止,这意味着未来数字扩展的收益不再得到保证。这是特定领域架构的主要驱动力之一。

特定领域计算意味着灵活性的价值已经降低,这在过去对模拟是不利的。

许多系统将变成多芯片架构,并且每个芯片不必在同一个技术节点中实现。这可能会使旧的、更便宜的节点可用于模拟工艺。

AI 推理在很大程度上依赖于乘法/累加运算,这在模拟中非常高效。

近似计算可能会变得更加普遍。

延迟正在成为更重要的性能要求。

“世界是模拟的,所以电路也是。”Fraunhofer IIS 自适应系统部工程高级混合信号自动化组经理 Benjamin Prautsch 说。 “有些类别的 IP 从全数字替代中受益匪浅。但是,由于模拟和数字之间的转换会产生限制,因此需要在系统级别研究其好处。一个聪明的模拟电路可能会胜过使用数字辅助的中等电路,其中将有许多因素和性能指标会发挥作用。”

除了传感器和执行器之外,无线通信也变得越来越重要。 “过去一切都是有线的,”Ansys 产品营销总监 Marc Swinnen 说。“今天,每个物联网设备都需要无线连接。他们正在使用无线电通信,这创造出越来越多的模拟和射频内容。此外,当您查看数字信号频率时,它们一直在攀升。 5GHz 是一个神奇的数字,在这里电感将成为一个重要的参与者,即使在芯片级也是如此。然后,必须考虑电磁效应。如果您想正确分析这些数字信号,就必须用模拟技术。当您查看 2.5D 和 3D 结构时,这是一个更大的问题,就芯片而言,连接线速率高同时还要走很远。”

制造进展

随着每个新节点的出现,数字电路的性能都得到了改善。面积下降,性能上升,功率下降,电容下降。然而,对于模拟来说,情况并非如此。每个新节点通常都与电压降低相关联,这会损害模拟性能,因为它会降低噪声容限,这对模拟电路的影响远大于对数字电路的影响。 同时,FinFET也对模拟有限制。

这导致模拟不得不做出妥协。西门子 EDA 的、产品经理 Sumit Vishwakarma 说:“如果你在单个芯片上制造所有东西,比如说 12nm,那么模拟需要转移到相同的工艺节点。你被迫失去模拟性能。随着模拟的性能在较先进的技术节点开始恶化,它需要一些额外帮助。这就是我们看到数字辅助模拟设计火热的原因。”

当模拟和数字解耦并使用合适的技术时,模拟电路不会受到影响。 Semtech 信号完整性解决方案集团营销和应用副总裁 Tim Vang 说:“模拟电路在某些情况下可以提供与数字等效甚至更好的功能,而且我们可以在较旧的节点上做到这一点。成本可以更低,因为我们不需要所有的数字功能,因此芯片尺寸可以更小。我们可以降低功耗,因为我们没有那么多功能。”

模拟也可以利用更多的制造技术。“即使在模拟中,你可以从任何工艺节点中获得的益处都是有限度的。”Vang 补充道。“如果你想使用 CMOS,我们甚至可以在 65nm 上开发。我们还使用其他工艺,例如 BiCMOS 或硅锗。它们可能更适合与光学器件连接。光学器件通常喜欢将信号表示为电流,而不是电压,而双极工艺非常擅长驱动这些电流。”

随着小芯片获得更多关注,使这些技术决策增加了更多的灵活性。 Mythic 负责产品和业务开发的高级副总裁 Tim Vehling 说:“小芯片或用于集成逻辑或功能的异构方法非常有意义。理论上,我们可以将模拟计算部分保留在 40nm 或 28nm 上。然后,您可以将其与具有处理器、内存和 I/O 的数字小芯片相匹配,并且可能是10nm。它们可以集成到单个封装或单个堆叠架构中。随着小芯片的出现,模拟的寿命越来越长。”

它还为光学创造了优势。 “在 IEEE 和其他标准组中,他们使用共同封装光学器件或板载光学器件之类的词,这一切都是为了使光学互连更接近交换机和CPU,”Vang 说。“这主要是为了节省用于将整个电路板驱动到位于光学器件的功率。这些是当今使用的可插拔模块。他们一直在推动使模拟光学器件越来越接近板上的数字开关,以降低高速下的功率消耗。我们认为这是一个巨大的机会,实际上它们将像带有光学 I/O 的小芯片。”

延迟是一个性能指标,它给数字带来了困难。 “我们以数字引擎的一小部分速度运行我们的模拟引擎,”Vehling 说。 “我们在兆赫范围内运行,而不是千兆赫范围。由于数据移动,数字架构要抵抗延迟。使用模拟解决方案,权重是固定的,计算在元素本身内部。从延迟的角度来看,即使在兆赫兹范围内,我们也比数字架构更快。”

这对通信系统有很大的好处。Vang 说。 “没有 A-D 转换、数字处理,然后是另一端的 D-A转换。该解决方案本质上是零延迟,或接近零延迟。如果您谈论的是从纽约到洛杉矶的互连,那么延迟并不那么重要,但如果您尝试在数据中心内走几米,那么延迟的节省就很重要了。对于超级计算机用户而言,模拟具有一些独特的优势:成本、功耗和延迟。”

来自 AI 的不断变化的需求

数字世界是非常精确、可预测和确定的。这些要求对模拟有效,但这种情况正在改变。 “使用人工智能,准确性取决于模型,”Vehling 说。 “根据他们选择的模型,准确性会发生变化。如果您选择更大的模型,它将具有更好的准确性。较小的模型具有较低的准确性。如果您选择不同的精度,您将获得不同的准确度。如果您选择不同的分辨率,您的精度将会改变。如果您有不同的数据集或经过不同的训练,您的准确性将会改变。我们看到人们会修剪模型,因为他们想让模型更适合。如果修剪它,则会降低准确性。给定应用程序的模型精度在数字系统中可能以多种方式发生变化——可能与模拟系统中的变化方式不同,但今天肯定存在变化。在任何情况下,AI 模型的准确性都有很多种变体,更不用说数字与模拟了。”

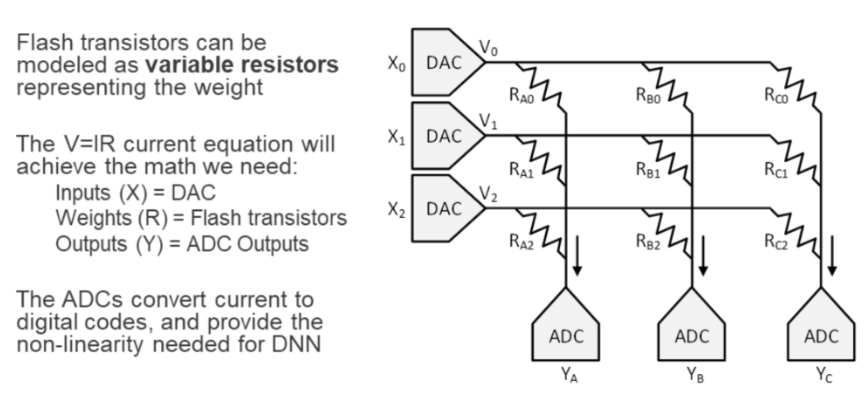

任何 AI 系统的核心都是乘法/累加函数(见图 2)。 “执行这些 MAC 操作所消耗的能量是巨大的,”西门子的 Vishwakarma 说。“部分原因是神经网络具有权重,而这些权重需要存储在内存中。他们必须不断地访问内存,这是一项非常耗能的任务。如果将计算能力与数据传输能力进行比较,几乎只有传输的1/10功耗。为了解决这个问题,公司和大学研究人员正在研究模拟计算,它将权重存储在闪存中。存内计算是权重存储在内存中的常用术语。现在我只需要输入一些输入并得到一个输出,这基本上是这些权重与我的输入的乘积。”

图 2:模拟电路实现 MAC 功能。来源:Myth

可以进行其他架构折衷。“你会看到脉冲神经网络被用于检测基于时间的变化,然后可以组合部署,”Vehling 说。“你可能会看到一个尖峰神经网络被部署在传感器级别上,以检测变化或运动。一旦发生这种检测后,您就会转向更详细或更精确的模型来识别对象。因此,您已经开始看到一些基于分层部署的AI方法。”

但也有障碍。 “原则上,全模拟解决方案应该更加节能,”Movellus 总裁兼首席执行官 Mo Faisal 说。 “但在混合设计中实现模拟效率的承诺并不容易。对于大多数公司来说,模拟具有挑战性,因为它不能缩微,并且在良率、性能和可扩展性方面令人失望。然而,对于少数人来说,模拟继续显示出前景和潜力。”

混合意味着需要更多转换器。“当你想将模拟基础设施插入数字世界时,你需要转换器,”Vishwakarma 说。“输入端需要 DAC,输出端需要 ADC。因此,这就是模拟将如何融入数字世界的连接方式,因为我们只需要模拟来解决计算密集型 MAC 操作。但世界其他地方都是数字化的。”

这是必须考虑系统级权衡的地方。“优化的模拟内核可以显着降低功耗和吞吐量,但它需要这些转换,”Fraunhofer 的 Prautsch 说。 “转换是否会减少模拟替代的好处是一个系统级决策,需要通过概念的建模和优化来分析。”

数字世界中的模拟

转换器的问题能克服吗? “如果你可以在模拟世界中进行数字化工作,那么效率将大大高于其他方式,”Vehling 说。“与其拥有一个隐藏在数字处理器中的模拟计算引擎,不如让我们真正拥有一个本地模拟处理器,从传感器中直接获取本地模拟信号进行计算而不是进行转换,这将是理想的。这将显着改善电源效率、性能和延迟。”

并非所有人都相信这是正确的方向。 Ambiq 的首席技术官兼创始人 Scott Hanson 表示:“将与计算相关的功能转移到模拟域绝对可以提供出色的性能和能源效率。几家创新型初创公司已经展示了出色的成果,并在这里积累了专业知识。然而,模拟计算的固有挑战(例如,较差的节点可扩展性、较长的设计时间、计算的不灵活性等)使其成为一个只有少数非常专业的专家才能成功的领域。”

相反,Hanson 着眼于实现技术的持续改进,以及跨节点迁移设计相当容易的事实。 “还有其他互补技术,如亚阈值和近阈值计算。流程节点缩放与亚阈值和近阈值计算的结合为令人兴奋的新 AI 功能提供了巨大的空间,所有这些都没有基于模拟的计算的复杂性。简而言之,我们押注于数字计算。”

模拟训练与推理

为了让模拟成为人工智能的主导引擎,它必须渗透到训练和推理中。 “如果您可以从激光雷达传感器、雷达、CMOS 图像传感器获取原始信号,而不是将其转换为数字然后返回,获取原始输入并将其馈送到模拟阵列,那么收益将是巨大的, ”Vehling说。 “但你必须训练系统以模拟方式识别数据。那就是模拟计算机的未来,一个真正的模拟系统。否则,我们不得不适应数字架构,尽管这会受到一些限制。”

“模拟信号的一个挑战是模拟信号的呈现方式没有限制,”西门子的 Vishwakarma 说。 “人工智能擅长识别模式,但我们不能只给它一个连续的信号。它需要离散化和量化。要训练模型,您将迭代地更新权重,直到它稳定到可用于推理的权重。然后我可以将权重保存在非易失性存储器中。但是,我们无法更改模拟权重的值,即闪存中电阻的值。一旦你加载它们,它就在那里。如果你需要改变权重,你需要像 DRAM 这样的随机存取存储器,这就是我们的问题所在。”

结论

有些事情模拟比数字做得更好,但最大的问题是如何将它们集成起来,以便在系统级产生所需的增益。然而,异构实现技术为每个子系统提供的潜在解耦可能使模拟计算更容易被考虑用于越来越多的功能。然后他们可以以更低的成本提供卓越的性能。

如果模拟计算变得更加普遍,那么很可能会研究和开发新的内存技术,这将使模拟人工智能成为可能。它可以提供数量级的增益。